ThreadPoolExecutor в Python: полное руководство

Исполнитель Python ThreadPoolExecutor позволяет создавать и управлять пулами потоков в Python.

Хотя ThreadPoolExecutor был доступен начиная с Python 3.2, он не получил широкого распространения, возможно, из-за непонимания возможностей и ограничений Threads в Python.

В этом руководстве подробно и всесторонне рассматривается ThreadPoolExecutor в Python, включая принцип его работы, способы использования, общие вопросы и лучшие практики.

Это огромное руководство, состоящее из 23 000+ слов. Возможно, вы захотите добавить его в закладки, чтобы обращаться к нему по мере разработки своих параллельных программ.

Давайте погрузимся внутрь.

Оглавление

- Потоки в Python и необходимость пулов потоков

- ThreadPoolExecutor для пулов потоков в Python

- Жизненный цикл ThreadPoolExecutor

- Пример работы с пулом потоков

- Шаблоны использования ThreadPoolExecutor

Потоки Python и необходимость пулов потоков

Итак, что такое потоки и почему мы заботимся о пулах потоков?

Что такое потоки Python

Поток относится к потоку выполнения компьютерной программы.

Каждая программа Python представляет собой процесс с одним потоком, называемым главным, который используется для выполнения инструкций вашей программы. Каждый процесс - это фактически один экземпляр интерпретатора Python, который выполняет инструкции Python (байткод Python), что является немного более низким уровнем, чем код, который вы вводите в свою программу Python.

Иногда нам может понадобиться создать дополнительные потоки в нашем процессе Python для одновременного выполнения задач.

Дополнительно вы можете ознакомится с основами потоков в Python.

Python предоставляет настоящие наивные (системного уровня) потоки через класс threading.Thread.

Задачу можно запустить в новом потоке, создав экземпляр класса Thread и указав функцию для запуска в новом потоке через аргумент target.

# create and configure a new thread to run a function

thread = Thread(target=task)

После создания потока его необходимо запустить, вызвав функцию start().

# start the task in a new thread

thread.start()

Затем мы можем подождать завершения задачи, присоединившись к потоку; например

# wait for the task to complete

thread.join()

Мы можем продемонстрировать это на полном примере с задачей, которая засыпает на мгновение и печатает сообщение.

Ниже приведен полный пример выполнения функции целевой задачи в отдельном потоке.

# SuperFastPython.com

# example of executing a target task function in a separate thread

from time import sleep

from threading import Thread

# a simple task that blocks for a moment and prints a message

def task():

# block for a moment

sleep(1)

# display a message

print('This is coming from another thread')

# create and configure a new thread to run a function

thread = Thread(target=task)

# start the task in a new thread

thread.start()

# display a message

print('Waiting for the new thread to finish...')

# wait for the task to complete

thread.join()

Запуск примера создает объект потока для выполнения функции task().

Поток запускается, а функция task() выполняется в другом потоке. Задача на мгновение засыпает; тем временем в главном потоке печатается сообщение о том, что мы ждем, и главный поток присоединяется к новому потоку.

Наконец, новый поток заканчивает спать, печатает сообщение и закрывается. После этого основной поток продолжает работу и также закрывается, поскольку больше нет инструкций для выполнения.

Waiting for the new thread to finish...

This is coming from another thread

Подробнее о потоках Python вы можете узнать из руководства:

Это полезно для выполнения разовых специальных задач в отдельном потоке, но становится громоздким, когда нужно выполнить много задач.

Каждый создаваемый поток требует применения ресурсов (например, памяти для стекового пространства потока). Вычислительные затраты на создание потоков могут стать дорогостоящими, если мы будем создавать и уничтожать множество потоков снова и снова для решения специальных задач.

Вместо этого мы предпочли бы сохранить рабочие потоки для повторного использования, если мы ожидаем выполнения множества специальных задач в нашей программе.

Этого можно добиться с помощью пула потоков.

Что такое пулы потоков

Пул потоков - это шаблон программирования для автоматического управления пулом рабочих потоков.

Пул отвечает за фиксированное количество потоков.

- Он управляет тем, когда создаются потоки, например, непосредственно в момент, когда они необходимы.

- Он также контролирует, что должны делать потоки, когда они не используются, например, заставлять их ждать, не потребляя вычислительных ресурсов.

Каждый поток в пуле называется рабочим или рабочей нитью. Каждый рабочий поток не зависит от типа выполняемых задач, а пользователь пула потоков может выполнять набор схожих (однородных) или несхожих (разнородных) задач с точки зрения вызываемой функции, аргументов функции, длительности задачи и т. д.

Рабочие потоки предназначены для повторного использования после завершения задачи и обеспечивают защиту от неожиданного сбоя задачи, например, от возникновения исключения, не затрагивая сам рабочий поток.

В отличие от одиночного потока, который настроен на выполнение одной конкретной задачи.

Пул может предоставлять некоторые возможности для настройки рабочих потоков, например, запуск функции инициализации и именование каждого рабочего потока с использованием определенного соглашения об именовании.

Пулы потоков могут предоставить общий интерфейс для выполнения специальных задач с переменным числом аргументов, но не требуют выбора потока для выполнения задачи, запуска потока или ожидания завершения задачи.

Использование пула потоков вместо ручного запуска, управления и закрытия потоков может быть значительно эффективнее, особенно при большом количестве задач.

Python предоставляет пул потоков с помощью класса ThreadPoolExecutor.

Запускайте циклы, используя все процессоры, скачайте БЕСПЛАТНУЮ книгу, чтобы узнать, как это сделать.

ThreadPoolExecutor для пулов потоков в Python

Класс ThreadPoolExecutor Python используется для создания и управления пулами потоков и предоставляется в модуле concurrent.futures.

Модуль concurrent.futures появился в Python 3.2, написанном Брайаном Куинланом, и предоставляет как пулы потоков, так и пулы процессов, хотя в этом руководстве мы сосредоточим свое внимание на пулах потоков.

Если вам интересно, вы можете получить доступ к исходному коду класса ThreadPoolExecutor на языке Python непосредственно через thread.py. Возможно, будет интересно разобраться с тем, как класс работает внутри, после того, как вы ознакомитесь с тем, как он работает снаружи.

Класс ThreadPoolExecutor расширяет класс Executor и при вызове будет возвращать объекты Future.

- Executor: Родительский класс для ThreadPoolExecutor, определяющий основные операции жизненного цикла пула.

- Future: Объект, возвращаемый при отправке задач в пул потоков, которые могут завершиться позже.

Давайте подробнее рассмотрим Executors, Futures и жизненный цикл использования класса ThreadPoolExecutor.

Что такое душеприказчики

Класс ThreadPoolExecutor расширяет абстрактный класс Executor.

Класс Executor определяет три метода, используемые для управления нашим пулом потоков; это: submit(), map() и shutdown().

- submit(): Отправляйте функцию на выполнение и возвращайте будущий объект.

- map(): Применяет функцию к итерируемому множеству элементов.

- shutdown(): Завершение работы исполнителя.

При создании класса запускается Executor, который должен быть выключен явным образом вызовом shutdown(), что приведет к освобождению всех ресурсов, удерживаемых Executor. Мы также можем завершить работу автоматически, но об этом мы поговорим чуть позже.

Функции submit() и map() используются для отправки задач исполнителю для асинхронного выполнения.

Функция map() работает так же, как и встроенная функция map(), и используется для применения функции к каждому элементу итерируемого объекта, например списка. В отличие от встроенной функции map(), каждое применение функции к элементу будет происходить асинхронно, а не последовательно.

Функция submit() принимает функцию, а также любые аргументы и выполняет ее асинхронно, хотя вызов возвращается немедленно и предоставляет объект Future.

В ближайшее время мы рассмотрим каждую из этих трех функций подробнее. Во-первых, что такое будущее?

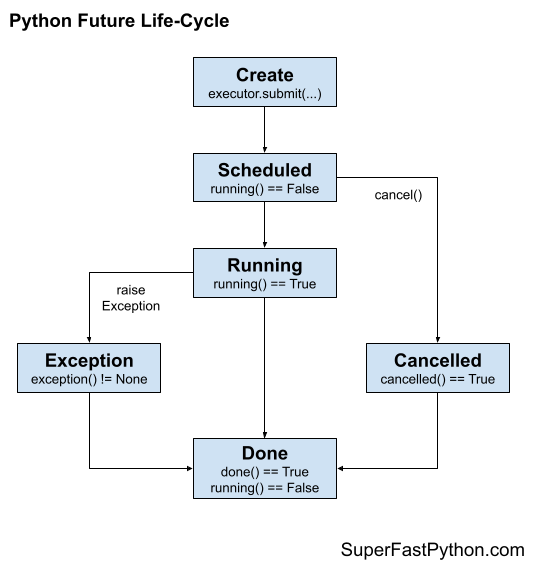

Что такое фьючерсы

Будущее - это объект, который представляет отложенный результат для асинхронной задачи.

Иногда его также называют обещанием или отсрочкой. Он обеспечивает контекст для результата задачи, которая может выполняться или не выполняться, и способ получения результата, как только он станет доступен.

В Python объект Future возвращается из Executor, например ThreadPoolExecutor при вызове функции submit() для отправки задачи на асинхронное выполнение.

В общем случае мы не создаем объекты Future; мы только получаем их, и нам может понадобиться вызвать функции для них.

Всегда существует один объект Future для каждой задачи, отправленной в ThreadPoolExecutor через вызов submit().

Объект Future предоставляет ряд полезных функций для проверки состояния задачи, таких как: cancelled(), running() и done(), чтобы определить, была ли задача отменена, выполняется ли она в данный момент или завершила выполнение.

- cancelled(): Возвращает True, если задача была отменена до выполнения.

- running(): Возвращает True, если задача в данный момент запущена.

- done(): Возвращает True, если задача завершилась или была отменена.

Выполненное задание не может быть отменено, а выполненное задание могло быть отменено.

Объект Future также предоставляет доступ к результату выполнения задачи через функцию result(). Если при выполнении задачи было поднято исключение, оно будет повторно поднято при вызове функции result() или может быть доступно через функцию exception().

- result(): Доступ к результату выполнения задачи.

- exception(): Доступ к любому исключению, возникшему во время выполнения задачи.

В функциях result() и exception() можно указать в качестве аргумента таймаут - количество секунд, в течение которых следует ждать возврата значения, если задача еще не завершена. Если таймаут истечет, то будет выдано сообщение TimeoutError.

Наконец, мы можем захотеть, чтобы пул потоков автоматически вызывал функцию после завершения задачи.

Этого можно добиться, присоединив обратный вызов к объекту Future для задачи с помощью функции add_done_callback().

- add_done_callback(): Добавляет к задаче функцию обратного вызова, которая будет выполнена пулом потоков после завершения задачи.

Мы можем добавить более одного обратного вызова к каждой задаче, и они будут выполняться в том порядке, в котором были добавлены. Если задача уже завершилась до того, как мы добавили обратный вызов, то обратный вызов будет выполнен немедленно.

Любые исключения, возникающие в функции обратного вызова, не влияют на задачу или пул потоков.

Более подробно мы рассмотрим объект Future в одном из следующих разделов.

Теперь, когда мы знакомы с функциональностью ThreadPoolExecutor, предоставляемой классом Executor, и с объектами Future, возвращаемыми вызовом submit(), давайте подробнее рассмотрим жизненный цикл класса ThreadPoolExecutor.

Запутались в API класса ThreadPoolExecutor? Скачайте БЕСПЛАТНУЮ шпаргалку PDF

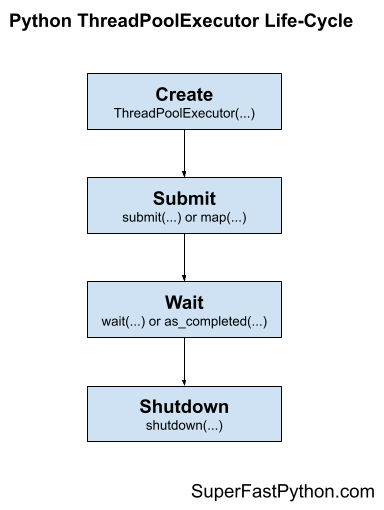

Жизненный цикл ThreadPoolExecutor

Исполнитель ThreadPoolExecutor предоставляет пул общих рабочих потоков.

Исполнитель ThreadPoolExecutor был разработан, чтобы быть простым и понятным в использовании.

Если бы многопоточность была похожа на коробку передач для переключения передач в автомобиле, то использование threading.Thread - это ручная коробка передач (например, трудно изучить и использовать), тогда как concurrency.futures.ThreadPoolExecutor - это автоматическая коробка передач (например, легко изучить и использовать).

- threading.Thread: Ручное управление потоками в Python.

- concurrency.futures.ThreadPoolExecutor: Автоматический или "просто работающий" режим для работы с потоками в Python.

В жизненном цикле использования класса ThreadPoolExecutor есть четыре основных этапа: создание, отправка, ожидание и завершение работы.

- 1. Создание: Создайте пул потоков, вызвав конструктор ThreadPoolExecutor().

- 2. Отправка: Отправляйте задания и получайте фьючерсы, вызывая submit() или map().

- 3. Ожидание: Ожидание и получение результатов по мере выполнения задач (необязательно).

- 4. Завершение работы: Выключите пул потоков, вызвав shutdown().

Следующий рисунок помогает представить жизненный цикл класса ThreadPoolExecutor.

Давайте рассмотрим каждый этап жизненного цикла по очереди.

Шаг 1. Создание пула потоков

Сначала необходимо создать экземпляр ThreadPoolExecutor.

При создании экземпляра ThreadPoolExecutor он должен быть настроен на фиксированное количество потоков в пуле, префикс, используемый при именовании каждого потока в пуле, и имя функции для вызова при инициализации каждого потока вместе с аргументами для функции.

Пул создается с одним потоком для каждого процессора в вашей системе плюс четыре. Это подходит для большинства целей.

- По умолчанию

Общее количество потоков = (Общее количество CPU) + 4

Например, если у вас 4 процессора, каждый с гиперпоточностью (большинство современных процессоров имеют ее), то Python увидит 8 процессоров и выделит (8 + 4) или 12 потоков в пул по умолчанию.

# create a thread pool with the default number of worker threads

executor = ThreadPoolExecutor()

Неплохо бы протестировать ваше приложение, чтобы определить количество потоков, обеспечивающее наилучшую производительность, - от нескольких до сотен потоков.

Обычно не стоит иметь тысячи потоков, так как это может повлиять на объем доступной оперативной памяти и привести к большому количеству переключений между потоками, что может привести к ухудшению производительности.

Подробнее о настройке количества потоков для вашего пула мы поговорим позже.

Вы можете указать количество потоков для создания пула с помощью аргумента max_workers; например:

# create a thread pool with 10 worker threads

executor = ThreadPoolExecutor(max_workers=10)

Шаг 2. Передача заданий в пул потоков

После создания пула потоков можно отправлять задания на асинхронное выполнение.

Как уже говорилось, существует два основных подхода к представлению задач, определенных на родительском классе Executor. Это map() и submit().

Шаг 2a. Передача заданий с помощью map()

Функция map() - это асинхронная версия встроенной функции map() для применения функции к каждому элементу итерируемого объекта, например списка.

Вы можете вызвать функцию map() на пуле и передать ей имя вашей функции и итерируемую переменную.

Вы, скорее всего, используете map() при преобразовании цикла for для запуска с использованием одного потока на итерацию цикла.

# perform all tasks in parallel

results = pool.map(my_task, my_items) # does not block

Где "my_task" - это ваша функция, которую вы хотите выполнить, а "my_items" - это итерация объектов, каждый из которых будет выполнен вашей функцией "my_task".

Задачи будут ставиться в очередь в пуле потоков и выполняться рабочими потоками в пуле по мере их поступления.

Функция map() сразу же возвращает итерируемый объект. Эта итерабель может быть использована для доступа к результатам из целевой функции задачи, поскольку они доступны в том порядке, в котором были представлены задачи (например, в порядке предоставленной вами итерабели).

# iterate over results as they become available

for result in executor.map(my_task, my_items):

print(result)

Вы также можете задать таймаут при вызове map() через аргумент "timeout" в секундах, если вы хотите установить ограничение на время ожидания завершения каждой задачи в процессе итерации, после чего будет выдана ошибка TimeOut.

# perform all tasks in parallel

# iterate over results as they become available

for result in executor.map(my_task, my_items, timeout=5):

# wait for task to complete or timeout expires

print(result)

2a. Отправить задание с помощью submit()

Функция submit() отправляет одну задачу в пул потоков для выполнения.

Функция принимает имя вызываемой функции и все аргументы к ней, а затем немедленно возвращает объект Future.

Объект Future представляет собой обещание вернуть результаты выполнения задачи (если таковые имеются) и обеспечивает способ определения того, была ли конкретная задача выполнена или нет.

# submit a task with arguments and get a future object

future = executor.submit(my_task, arg1, arg2) # does not block

Где "my_task" - это функция, которую вы хотите выполнить, а "arg1" и "arg2" - первый и второй аргументы для передачи в функцию "my_task".

Вы можете использовать функцию submit() для отправки заданий, которые не принимают никаких аргументов; например:

# submit a task with no arguments and get a future object

future = executor.submit(my_task) # does not block

Получить доступ к результату выполнения задачи можно с помощью функции result() на возвращаемом объекте Future. Этот вызов будет блокироваться до тех пор, пока задача не будет завершена.

# get the result from a future

result = future.result() # blocks

Вы также можете задать таймаут при вызове result() с помощью аргумента "timeout" в секундах, если хотите установить ограничение на время ожидания завершения каждой задачи, по истечении которого будет выдана ошибка TimeOut.

# wait for task to complete or timeout expires

result = future.result(timeout=5) # blocks

Шаг 3. Дождитесь завершения заданий (необязательно)

Модуль concurrent.futures предоставляет две служебные функции модуля для ожидания задач через их объекты Future.

Напомните, что объекты Future создаются только тогда, когда мы вызываем submit(), чтобы поместить задачи в пул потоков.

Эти функции ожидания использовать необязательно, так как вы можете ждать результатов непосредственно после вызова map() или submit() или дождаться завершения всех задач в пуле потоков.

Эти две функции модуля - wait() для ожидания завершения работы объектов Future и as_completed() для получения объектов Future по мере завершения их задач.

- wait(): Ожидание одного или нескольких объектов Future до их завершения.

- as_completed(): Возвращает объекты Future из коллекции по мере завершения их выполнения.

Вы можете использовать обе функции с объектами Future, созданными одним или несколькими пулами потоков, они не являются специфичными для какого-либо конкретного пула потоков в вашем приложении. Это удобно, если вы хотите выполнять операции ожидания в нескольких пулах потоков, выполняющих различные типы задач.

Обе функции полезно использовать с идиомой отправки нескольких задач в пул потоков через submit в сжатии списка; например:

# dispatch tasks into the thread pool and create a list of futures

futures = [executor.submit(my_task, my_data) for my_data in my_datalist]

Здесь my_task - это наша пользовательская целевая функция задачи, "my_data" - это один элемент данных, переданный в качестве аргумента "my_task", а "my_datalist" - это наш источник объектов my_data.

Затем мы можем передать объекты Future в wait() или as_completed().

Создание списка объектов Future таким образом не является обязательным, просто это обычная схема при преобразовании циклов for в задачи, передаваемые в пул потоков.

Шаг 3a. Дождитесь завершения фьючерсов

Функция wait() может принимать один или несколько объектов Future и вернется, когда произойдет указанное действие, например, все задания завершатся, одно задание завершится, или одно задание вызовет исключение.

Функция вернет один набор объектов Future, которые соответствуют условию, заданному через "return_when". Второй набор будет содержать все фьючерсы для задач, не удовлетворяющих условию. Эти наборы фьючерсов называются "done" и "not_done".

Это полезно для ожидания большой партии работы и для прекращения ожидания, когда мы получим первый результат.

Это можно сделать с помощью константы FIRST_COMPLETED, передаваемой в аргументе "return_when".

# wait until we get the first result

done, not_done = wait(futures, return_when=concurrent.futures.FIRST_COMPLETED)

В качестве альтернативы мы можем дождаться завершения всех задач с помощью константы ALL_COMPLETED.

Это может быть полезно, если вы используете submit() для отправки заданий и ищете простой способ дождаться завершения всей работы.

# wait for all tasks to complete

done, not_done = wait(futures, return_when=concurrent.futures.ALL_COMPLETED)

Также есть возможность дождаться первого исключения с помощью константы FIRST_EXCEPTION.

# wait for the first exception

done, not_done = wait(futures, return_when=concurrent.futures.FIRST_EXCEPTION)

Шаг 3b. Ожидание фьючерсов как завершенное

Прелесть одновременного выполнения задач в том, что мы можем получать результаты по мере их поступления, а не ждать, пока все задачи будут завершены.

Функция as_completed() будет возвращать объекты Future для задач по мере их завершения в пуле потоков.

Мы можем вызвать функцию и предоставить ей список объектов Future, созданных вызовом submit(), и она будет возвращать объекты Future по мере их завершения в любом порядке.

Обычно функция as_completed() используется в цикле по списку объектов Future, созданных при вызове submit; например:

# iterate over all submitted tasks and get results as they are available

for future in as_completed(futures):

# get the result for the next completed task

result = future.result() # blocks

Примечание: это отличается от итерации по результатам вызова map() двумя способами. Во-первых, map() возвращает итератор над объектами, а не над объектами Future. Во-вторых, map() возвращает результаты в том порядке, в котором задания были поданы, а не в том, в котором они были выполнены.

Шаг 4. Выключите пул потоков

После выполнения всех задач мы можем закрыть пул потоков, что приведет к освобождению каждого потока и всех ресурсов, которые он может занимать (например, пространства стека потоков).

# shutdown the thread pool

executor.shutdown() # blocks

Функция shutdown() по умолчанию будет ждать завершения всех задач в пуле потоков перед возвратом.

Это поведение можно изменить, установив аргумент "wait" в значение False при вызове shutdown(), в этом случае функция вернется немедленно. Ресурсы, используемые пулом потоков, не будут освобождены до тех пор, пока все текущие и поставленные в очередь задачи не будут завершены.

# shutdown the thread pool

executor.shutdown(wait=False) # does not blocks

Мы также можем поручить пулу отменить все поставленные в очередь задачи, чтобы предотвратить их выполнение. Этого можно добиться, установив аргумент "cancel_futures" в значение True. По умолчанию поставленные в очередь задачи не отменяются при вызове shutdown().

# cancel all queued tasks

executor.shutdown(cancel_futures=True) # blocks

Если мы забудем закрыть пул потоков, он будет закрыт автоматически при выходе из главного потока. Если мы забудем закрыть пул, а задачи все еще будут выполняться, главный поток не завершится, пока не будут выполнены все задачи в пуле и все поставленные в очередь задачи.

Контекстный менеджер ThreadPoolExecutor

Предпочтительным способом работы с классом ThreadPoolExecutor является использование менеджера контекста.

Это соответствует предпочтительному способу работы с другими ресурсами, такими как файлы и сокеты.

Использование ThreadPoolExecutor с контекстным менеджером предполагает использование ключевого слова "with" для создания блока, в котором вы можете использовать пул потоков для выполнения задач и получения результатов.

После завершения блока пул потоков автоматически закрывается. Внутренне менеджер контекста вызовет функцию shutdown() с аргументами по умолчанию, ожидая завершения всех поставленных в очередь и выполняющихся задач, после чего вернется и продолжит работу.

Ниже приведен фрагмент кода, демонстрирующий создание пула потоков с помощью менеджера контекста.

# create a thread pool

with ThreadPoolExecutor(max_workers=10) as pool:

# submit tasks and get results

# ...

# automatically shutdown the thread pool...

# the pool is shutdown at this point

Это очень удобная идиома, если вы преобразуете цикл for в многопоточный.

Это менее полезно, если вы хотите, чтобы пул потоков работал в фоновом режиме, пока вы выполняете другую работу в основном потоке вашей программы, или если вы хотите повторно использовать пул потоков несколько раз в течение вашей программы.

Теперь, когда мы знакомы с тем, как использовать ThreadPoolExecutor, давайте рассмотрим несколько работающих примеров.

Пример работы с пулом потоков (ThreadPoolExecutor)

В этом разделе мы рассмотрим более полный пример использования ThreadPoolExecutor.

Пожалуй, самым распространенным вариантом использования ThreadPoolExecutor является одновременная загрузка файлов из Интернета.

Это полезная проблема, потому что существует множество способов загрузки файлов. Мы будем использовать эту задачу в качестве основы для изучения различных паттернов с ThreadPoolExecutor для одновременной загрузки файлов.

Для начала разработаем серийную (неконкурентную) версию программы.

Серийная загрузка файлов

Рассмотрим ситуацию, когда мы можем захотеть иметь локальную копию некоторой документации Python API по параллелизму для последующего просмотра.

Возможно, мы летим на самолете, и у нас не будет доступа к интернету, а нам нужно будет обратиться к документации в формате HTML, как она представлена на сайте docs.python.org. Это надуманный сценарий; Python устанавливается вместе с docs, и у нас также есть команда pydoc, но согласитесь со мной.

Мы можем захотеть загрузить локальные копии следующих десяти URL-адресов, которые охватывают все возможности Python concurrency API.

Мы можем определить эти URL как список строк для обработки в нашей программе.

# python concurrency API docs

URLS = ['https://docs.python.org/3/library/concurrency.html',

'https://docs.python.org/3/library/concurrent.html',

'https://docs.python.org/3/library/concurrent.futures.html',

'https://docs.python.org/3/library/threading.html',

'https://docs.python.org/3/library/multiprocessing.html',

'https://docs.python.org/3/library/multiprocessing.shared_memory.html',

'https://docs.python.org/3/library/subprocess.html',

'https://docs.python.org/3/library/queue.html',

'https://docs.python.org/3/library/sched.html',

'https://docs.python.org/3/library/contextvars.html']

URL достаточно легко загружаются в Python.

Сначала мы можем попытаться открыть соединение с сервером с помощью функции urllib.request.urlopen(), указав URL и разумный тайм-аут в секундах.

Это создаст соединение, по которому мы сможем вызвать функцию read() для чтения содержимого файла. Использование контекстного менеджера для соединения обеспечит его автоматическое закрытие, даже если возникнет исключение.

Приведенная ниже функция download_url() реализует это, принимая в качестве параметра URL и возвращая содержимое файла или None, если файл по какой-то причине не может быть загружен. Мы установим длительный таймаут в 3 секунды на случай, если наше интернет-соединение по какой-то причине окажется нестабильным.

# download a url and return the raw data, or None on error

def download_url(url):

try:

# open a connection to the server

with urlopen(url, timeout=3) as connection:

# read the contents of the html doc

return connection.read()

except:

# bad url, socket timeout, http forbidden, etc.

return None

Получив данные для URL, мы можем сохранить их в локальном файле.

Сначала нам нужно получить имя файла, указанного в URL. Существует несколько способов сделать это, но функция os.path.basename() является общепринятым подходом при работе с путями. Затем мы можем использовать функцию os.path.join() для построения выходного пути для сохранения файла, используя указанную нами директорию и имя файла.

Затем мы можем использовать встроенную функцию open(), чтобы открыть файл в режиме записи двоичных файлов и сохранить его содержимое, снова используя менеджер контекста, чтобы убедиться, что файл закрыт, когда мы закончим.

Приведенная ниже функция save_file() реализует это, принимая URL, который был загружен, содержимое файла, который был загружен, и локальный путь вывода, где мы хотим сохранить загруженные файлы. Она возвращает путь вывода, который был использован для сохранения файла, на случай, если мы хотим сообщить пользователю о прогрессе.

# save data to a local file

def save_file(url, data, path):

# get the name of the file from the url

filename = basename(url)

# construct a local path for saving the file

outpath = join(path, filename)

# save to file

with open(outpath, 'wb') as file:

file.write(data)

return outpath

Далее мы можем вызвать функцию download_url() для заданного URL в нашем списке, а затем save_file() для сохранения каждого загруженного файла.

Приведенная ниже функция download_and_save() реализует это, сообщая о ходе выполнения и обрабатывая URL-адреса, которые не могут быть загружены.

# download and save a url as a local file

def download_and_save(url, path):

# download the url

data = download_url(url)

# check for no data

if data is None:

print(f'>Error downloading {url}')

return

# save the data to a local file

outpath = save_file(url, data, path)

# report progress

print(f'>Saved {url} to {outpath}')

Наконец, нам нужна функция, которая будет управлять процессом.

Во-первых, необходимо создать локальное место вывода, куда мы будем сохранять файлы, если оно не существует. Этого можно добиться с помощью функции os.makedirs().

Мы можем перебирать список URL-адресов и вызывать нашу функцию download_and_save() для каждого из них.

Приведенная ниже функция download_docs() реализует this.

# download a list of URLs to local files

def download_docs(urls, path):

# create the local directory, if needed

makedirs(path, exist_ok=True)

# download each url and save as a local file

for url in urls:

download_and_save(url, path)

И это все.

Затем мы можем вызвать нашу download_docs() со списком URL-адресов и выходным каталогом. В данном случае мы будем использовать подкаталог 'docs/' нашего текущего рабочего каталога (где находится Python-скрипт) в качестве выходного каталога.

Ниже приведен полный пример последовательной загрузки файлов.

# SuperFastPython.com

# download document files and save to local files serially

from os import makedirs

from os.path import basename

from os.path import join

from urllib.request import urlopen

# download a url and return the raw data, or None on error

def download_url(url):

try:

# open a connection to the server

with urlopen(url, timeout=3) as connection:

# read the contents of the html doc

return connection.read()

except:

# bad url, socket timeout, http forbidden, etc.

return None

# save data to a local file

def save_file(url, data, path):

# get the name of the file from the url

filename = basename(url)

# construct a local path for saving the file

outpath = join(path, filename)

# save to file

with open(outpath, 'wb') as file:

file.write(data)

return outpath

# download and save a url as a local file

def download_and_save(url, path):

# download the url

data = download_url(url)

# check for no data

if data is None:

print(f'>Error downloading {url}')

return

# save the data to a local file

outpath = save_file(url, data, path)

# report progress

print(f'>Saved {url} to {outpath}')

# download a list of URLs to local files

def download_docs(urls, path):

# create the local directory, if needed

makedirs(path, exist_ok=True)

# download each url and save as a local file

for url in urls:

download_and_save(url, path)

# python concurrency API docs

URLS = ['https://docs.python.org/3/library/concurrency.html',

'https://docs.python.org/3/library/concurrent.html',

'https://docs.python.org/3/library/concurrent.futures.html',

'https://docs.python.org/3/library/threading.html',

'https://docs.python.org/3/library/multiprocessing.html',

'https://docs.python.org/3/library/multiprocessing.shared_memory.html',

'https://docs.python.org/3/library/subprocess.html',

'https://docs.python.org/3/library/queue.html',

'https://docs.python.org/3/library/sched.html',

'https://docs.python.org/3/library/contextvars.html']

# local path for saving the files

PATH = 'docs'

# download all docs

download_docs(URLS, PATH)

При выполнении примера выполняется итерация по списку URL-адресов и загрузка каждого из них по очереди.

Затем каждый файл сохраняется в локальном файле в указанном каталоге.

Процесс занимает от 700 миллисекунд до одной секунды (1 000 миллисекунд) в моей системе.

Попробуйте запустить его несколько раз; сколько времени это займет на вашей системе?

Дайте мне знать в комментариях.

>Saved https://docs.python.org/3/library/concurrency.html to docs/concurrency.html

>Saved https://docs.python.org/3/library/concurrent.html to docs/concurrent.html

>Saved https://docs.python.org/3/library/concurrent.futures.html to docs/concurrent.futures.html

>Saved https://docs.python.org/3/library/threading.html to docs/threading.html

>Saved https://docs.python.org/3/library/multiprocessing.html to docs/multiprocessing.html

>Saved https://docs.python.org/3/library/multiprocessing.shared_memory.html to docs/multiprocessing.shared_memory.html

>Saved https://docs.python.org/3/library/subprocess.html to docs/subprocess.html

>Saved https://docs.python.org/3/library/queue.html to docs/queue.html

>Saved https://docs.python.org/3/library/sched.html to docs/sched.html

>Saved https://docs.python.org/3/library/contextvars.html to docs/contextvars.html

Далее мы можем посмотреть, как сделать программу параллельной, используя пул потоков.

Загрузка файлов одновременно с submit()

Давайте рассмотрим, как обновить нашу программу, чтобы использовать ThreadPoolExecutor для одновременной загрузки файлов.

Первой мыслью может быть использование map(), поскольку мы просто хотим сделать цикл for-loop concurrent.

К сожалению, функция download_and_save(), которую мы вызываем на каждой итерации цикла, принимает два параметра, только один из которых является итерируемым.

Альтернативный подход заключается в использовании submit() для вызова download_and_save() в отдельном потоке для каждого URL в предоставленном списке.

Для этого сначала нужно сконфигурировать пул потоков с количеством потоков, равным количеству URL в списке. Мы будем использовать менеджер контекста для пула потоков, чтобы он автоматически закрывался для нас, когда мы закончим работу.

Затем мы можем вызвать функцию submit() для каждого URL, используя сжатие списка. Нам даже не нужны объекты Future, возвращаемые при вызове submit, поскольку мы не ждем результата.

# create the thread pool

n_threads = len(urls)

with ThreadPoolExecutor(n_threads) as executor:

# download each url and save as a local file

_ = [executor.submit(download_and_save, url, path) for url in urls]

После завершения каждого потока менеджер контекста закроет для нас пул потоков, и мы закончим.

Нам даже не нужно добавлять явный вызов wait, хотя мы могли бы, если бы хотели сделать код более читабельным; например:

# create the thread pool

n_threads = len(urls)

with ThreadPoolExecutor(n_threads) as executor:

# download each url and save as a local file

futures = [executor.submit(download_and_save, url, path) for url in urls]

# wait for all download tasks to complete

_, _ = wait(futures)

Но добавлять это ожидание не нужно.

Ниже приведена обновленная версия нашей функции download_docs(), которая загружает и сохраняет файлы одновременно.

# download a list of URLs to local files

def download_docs(urls, path):

# create the local directory, if needed

makedirs(path, exist_ok=True)

# create the thread pool

n_threads = len(urls)

with ThreadPoolExecutor(n_threads) as executor:

# download each url and save as a local file

_ = [executor.submit(download_and_save, url, path) for url in urls]

Ниже приведен полный пример.

# SuperFastPython.com

# download document files and save to local files concurrently

from os import makedirs

from os.path import basename

from os.path import join

from urllib.request import urlopen

from concurrent.futures import ThreadPoolExecutor

# download a url and return the raw data, or None on error

def download_url(url):

try:

# open a connection to the server

with urlopen(url, timeout=3) as connection:

# read the contents of the html doc

return connection.read()

except:

# bad url, socket timeout, http forbidden, etc.

return None

# save data to a local file

def save_file(url, data, path):

# get the name of the file from the url

filename = basename(url)

# construct a local path for saving the file

outpath = join(path, filename)

# save to file

with open(outpath, 'wb') as file:

file.write(data)

return outpath

# download and save a url as a local file

def download_and_save(url, path):

# download the url

data = download_url(url)

# check for no data

if data is None:

print(f'>Error downloading {url}')

return

# save the data to a local file

outpath = save_file(url, data, path)

# report progress

print(f'>Saved {url} to {outpath}')

# download a list of URLs to local files

def download_docs(urls, path):

# create the local directory, if needed

makedirs(path, exist_ok=True)

# create the thread pool

n_threads = len(urls)

with ThreadPoolExecutor(n_threads) as executor:

# download each url and save as a local file

_ = [executor.submit(download_and_save, url, path) for url in urls]

# python concurrency API docs

URLS = ['https://docs.python.org/3/library/concurrency.html',

'https://docs.python.org/3/library/concurrent.html',

'https://docs.python.org/3/library/concurrent.futures.html',

'https://docs.python.org/3/library/threading.html',

'https://docs.python.org/3/library/multiprocessing.html',

'https://docs.python.org/3/library/multiprocessing.shared_memory.html',

'https://docs.python.org/3/library/subprocess.html',

'https://docs.python.org/3/library/queue.html',

'https://docs.python.org/3/library/sched.html',

'https://docs.python.org/3/library/contextvars.html']

# local path for saving the files

PATH = 'docs'

# download all docs

download_docs(URLS, PATH)

Запуск примера загружает и сохраняет файлы, как и прежде.

На этот раз операция завершается за доли секунды. В моем случае около 300 миллисекунд, что меньше половины времени, которое потребовалось для последовательной загрузки всех файлов в предыдущем примере.

Сколько времени заняла загрузка всех файлов в вашей системе?

>Saved https://docs.python.org/3/library/concurrent.html to docs/concurrent.html

>Saved https://docs.python.org/3/library/multiprocessing.shared_memory.html to docs/multiprocessing.shared_memory.html

>Saved https://docs.python.org/3/library/concurrency.html to docs/concurrency.html

>Saved https://docs.python.org/3/library/sched.html to docs/sched.html

>Saved https://docs.python.org/3/library/contextvars.html to docs/contextvars.html

>Saved https://docs.python.org/3/library/queue.html to docs/queue.html

>Saved https://docs.python.org/3/library/concurrent.futures.html to docs/concurrent.futures.html

>Saved https://docs.python.org/3/library/threading.html to docs/threading.html

>Saved https://docs.python.org/3/library/subprocess.html to docs/subprocess.html

>Saved https://docs.python.org/3/library/multiprocessing.html to docs/multiprocessing.html

Это один из подходов к созданию параллельной программы, но давайте рассмотрим некоторые альтернативы.

Загрузка файлов одновременно с submit() и as_completed()

Возможно, мы хотим сообщать о ходе загрузки по мере ее завершения.

Пул потоков позволяет нам сделать это, храня объекты Future, возвращаемые из вызовов submit(), а затем вызывая as_completed() на коллекции объектов Future.

Кроме того, учтите, что в задаче мы делаем две вещи. Первая - это загрузка с удаленного сервера, что является операцией, связанной с IO, которую мы можем выполнять одновременно. Вторая - сохранение содержимого файла на локальном жестком диске, что является еще одной операцией, связанной с IO, которую мы не можем выполнять одновременно, поскольку большинство жестких дисков могут сохранять только один файл за раз.

Поэтому, возможно, лучше сделать так, чтобы часть программы, связанная с загрузкой файла, была только параллельной задачей, а часть программы, связанная с сохранением файла, - последовательной.

Это потребует дополнительных изменений в программе.

Мы можем вызвать функцию download_url() для каждого URL, и это может быть нашей параллельной задачей, переданной в пул потоков.

Когда мы вызываем result() на каждом объекте Future, он выдает нам данные, которые были загружены, но мы не знаем, с какого URL они были загружены. Объект Future не будет знать.

Поэтому мы можем обновить download_url(), чтобы вернуть и данные, которые были загружены, и URL, который был предоставлен в качестве аргумента.

Ниже приведена обновленная версия функции download_url(), которая возвращает кортеж из данных и входного URL.

# download a url and return the raw data, or None on error

def download_url(url):

try:

# open a connection to the server

with urlopen(url, timeout=3) as connection:

# read the contents of the html doc

return (connection.read(), url)

except:

# bad url, socket timeout, http forbidden, etc.

return (None, url)

Затем мы можем отправить вызов этой функции на каждый URL в пул потоков, чтобы получить объект Future.

# download each url and save as a local file

futures = [executor.submit(download_url, url) for url in urls]

Пока все хорошо.

Теперь мы хотим сохранять локальные файлы и сообщать о ходе их загрузки.

Для этого нам необходимо уничтожить функцию download_and_save() и перенести ее обратно в функцию download_docs(), которая используется для управления программой.

Мы можем перебирать фьючерсы с помощью функции as_completed(), которая будет возвращать объекты Future в порядке завершения загрузки, а не в том порядке, в котором мы отправляли их в пул потоков.

Затем мы можем получить данные и URL из объекта Future.

# process each result as it is available

for future in as_completed(futures):

# get the downloaded url data

data, url = future.result()

Мы можем проверить, не была ли загрузка успешной, и сообщить об ошибке, в противном случае сохранить файл и сообщить о прогрессе, как обычно. Прямая копи-паста из функции download_and_save().

# check for no data

if data is None:

print(f'>Error downloading {url}')

continue

# save the data to a local file

outpath = save_file(url, data, path)

# report progress

print(f'>Saved {url} to {outpath}')

Ниже приведена обновленная версия нашей функции download_docs(), которая будет загружать файлы только одновременно, а затем сохранять их последовательно по мере загрузки.

# download a list of URLs to local files

def download_docs(urls, path):

# create the local directory, if needed

makedirs(path, exist_ok=True)

# create the thread pool

n_threads = len(urls)

with ThreadPoolExecutor(n_threads) as executor:

# download each url and save as a local file

futures = [executor.submit(download_url, url) for url in urls]

# process each result as it is available

for future in as_completed(futures):

# get the downloaded url data

data, url = future.result()

# check for no data

if data is None:

print(f'>Error downloading {url}')

continue

# save the data to a local file

outpath = save_file(url, data, path)

# report progress

print(f'>Saved {url} to {outpath}')

Ниже приведен полный пример.

# SuperFastPython.com

# download document files concurrently and save the files locally serially

from os import makedirs

from os.path import basename

from os.path import join

from urllib.request import urlopen

from concurrent.futures import ThreadPoolExecutor

from concurrent.futures import as_completed

# download a url and return the raw data, or None on error

def download_url(url):

try:

# open a connection to the server

with urlopen(url, timeout=3) as connection:

# read the contents of the html doc

return (connection.read(), url)

except:

# bad url, socket timeout, http forbidden, etc.

return (None, url)

# save data to a local file

def save_file(url, data, path):

# get the name of the file from the url

filename = basename(url)

# construct a local path for saving the file

outpath = join(path, filename)

# save to file

with open(outpath, 'wb') as file:

file.write(data)

return outpath

# download a list of URLs to local files

def download_docs(urls, path):

# create the local directory, if needed

makedirs(path, exist_ok=True)

# create the thread pool

n_threads = len(urls)

with ThreadPoolExecutor(n_threads) as executor:

# download each url and save as a local file

futures = [executor.submit(download_url, url) for url in urls]

# process each result as it is available

for future in as_completed(futures):

# get the downloaded url data

data, url = future.result()

# check for no data

if data is None:

print(f'>Error downloading {url}')

continue

# save the data to a local file

outpath = save_file(url, data, path)

# report progress

print(f'>Saved {url} to {outpath}')

# python concurrency API docs

URLS = ['https://docs.python.org/3/library/concurrency.html',

'https://docs.python.org/3/library/concurrent.html',

'https://docs.python.org/3/library/concurrent.futures.html',

'https://docs.python.org/3/library/threading.html',

'https://docs.python.org/3/library/multiprocessing.html',

'https://docs.python.org/3/library/multiprocessing.shared_memory.html',

'https://docs.python.org/3/library/subprocess.html',

'https://docs.python.org/3/library/queue.html',

'https://docs.python.org/3/library/sched.html',

'https://docs.python.org/3/library/contextvars.html']

# local path for saving the files

PATH = 'docs'

# download all docs

download_docs(URLS, PATH)

При запуске программы файлы загружаются и сохраняются, как и раньше, возможно, на несколько миллисекунд быстрее.

Взглянув на вывод программы, мы видим, что порядок сохраненных файлов отличается.

Маленькие файлы, такие как "sched.html", которые отправлялись почти последними, загружались быстрее (например, меньше байт для загрузки) и, в свою очередь, быстрее сохранялись в локальных файлах.

Это подтверждает, что мы действительно обрабатываем загрузки в порядке выполнения заданий, а не в порядке их подачи.

>Saved https://docs.python.org/3/library/concurrent.html to docs/concurrent.html

>Saved https://docs.python.org/3/library/sched.html to docs/sched.html

>Saved https://docs.python.org/3/library/concurrency.html to docs/concurrency.html

>Saved https://docs.python.org/3/library/contextvars.html to docs/contextvars.html

>Saved https://docs.python.org/3/library/queue.html to docs/queue.html

>Saved https://docs.python.org/3/library/multiprocessing.shared_memory.html to docs/multiprocessing.shared_memory.html

>Saved https://docs.python.org/3/library/threading.html to docs/threading.html

>Saved https://docs.python.org/3/library/concurrent.futures.html to docs/concurrent.futures.html

>Saved https://docs.python.org/3/library/subprocess.html to docs/subprocess.html

>Saved https://docs.python.org/3/library/multiprocessing.html to docs/multiprocessing.html

Теперь, когда мы увидели несколько примеров, давайте рассмотрим некоторые общие шаблоны использования ThreadPoolExecutor.

Озадачены ли вы параллельными API в python? Скачайте БЕСПЛАТНЫЕ Python Concurrency Mind Maps

Паттерны использования ThreadPoolExecutor

Последователь ThreadPoolExecutor обеспечивает большую гибкость для выполнения параллельных задач в Python.

Тем не менее, существует несколько общих моделей использования, которые подойдут для большинства программных сценариев.

В этом разделе перечислены общие шаблоны использования с примерами, которые вы можете скопировать и вставить в свой собственный проект и адаптировать по мере необходимости.

Мы рассмотрим следующие шаблоны:

- Обработка и ожидание шаблона

- Отправить и использовать как завершенный образец

- Отправить и использовать последовательно

- Отправить и использовать обратный вызов

- Отправить и дождаться всех шаблон

- Отправить и дождаться первого шаблона

В каждом примере мы будем использовать надуманную задачу, которая будет спать в течение случайного времени, меньшего, чем одна секунда. Вы можете легко заменить эту задачу на свою собственную в каждом примере.

Кроме того, напомним, что в каждой программе Python по умолчанию есть один поток, называемый главным, в котором мы и выполняем свою работу. Мы будем создавать пул потоков в главном потоке в каждом примере и можем ссылаться на действия в главном потоке в некоторых паттернах, в отличие от действий в потоках в пуле потоков.

Паттерн отображения и ожидания

Пожалуй, самый распространенный паттерн при использовании ThreadPoolExecutor - это преобразование цикла for, выполняющего функцию для каждого элемента коллекции, для использования потоков.

Предполагается, что функция не имеет побочных эффектов, то есть она не обращается к данным за пределами функции и не изменяет предоставленные ей данные. Она принимает данные и выдает результат.

Такие типы циклов for могут быть явно написаны в Python; например:

# apply a function to each element in a collection

for item in mylist:

result = task(item)

Лучше использовать встроенную функцию map(), которая применит функцию к каждому элементу итерабельной таблицы за вас.

# apply the function to each element in the collection

results = map(task, mylist)

Это не выполняет функцию task() для каждого элемента, пока мы не выполним итерацию результатов, так называемое ленивое оценивание:

# iterate the results from map

for result in results:

print(result)

Поэтому обычно эта операция сводится к следующему:

# iterate the results from map

for result in map(task, mylist):

print(result)

Мы можем выполнить эту же операцию, используя пул потоков, только каждое применение функции к элементу списка - это задача, которая выполняется асинхронно. Например:

# iterate the results from map

for result in executor.map(task, mylist):

print(result)

Хотя задачи выполняются параллельно, результаты итерируются в порядке итерируемой таблицы, предоставляемой функции map(), как и встроенной функции map().

Таким образом, мы можем рассматривать версию пула потоков map() как параллельную версию функции map(), и это идеальный вариант, если вы хотите обновить цикл for, чтобы использовать потоки.

Нижеприведенный пример демонстрирует использование шаблона map and wait с задачей, которая будет спать случайное количество времени меньше одной секунды и вернет указанное значение.

# SuperFastPython.com

# example of the map and wait pattern for the ThreadPoolExecutor

from time import sleep

from random import random

from concurrent.futures import ThreadPoolExecutor

# custom task that will sleep for a variable amount of time

def task(name):

# sleep for less than a second

sleep(random())

return name

# start the thread pool

with ThreadPoolExecutor(10) as executor:

# execute tasks concurrently and process results in order

for result in executor.map(task, range(10)):

# retrieve the result

print(result)

Запустив пример, мы видим, что результаты выдаются в том порядке, в котором задачи были созданы и отправлены в пул потоков.

0

1

2

3

4

5

6

7

8

9

Функция map() поддерживает целевые функции, принимающие более одного аргумента, путем предоставления более чем iterable в качестве аргументов при вызове map().

Например, мы можем определить целевую функцию для map, которая принимает два аргумента, а затем предоставить две итерации одинаковой длины для вызова map.

Полный пример приведен ниже.

# SuperFastPython.com

# example of calling map with two iterables

from time import sleep

from random import random

from concurrent.futures import ThreadPoolExecutor

# custom task that will sleep for a variable amount of time

def task(value1, value2):

# sleep for less than a second

sleep(random())

return (value1, value2)

# start the thread pool

with ThreadPoolExecutor() as executor:

# submit all tasks

for result in executor.map(task, ['1', '2', '3'], ['a', 'b', 'c']):

print(result)

Запуск примера выполняет задачи, как и ожидалось, предоставляя два аргумента для map и сообщая результат, который объединяет оба аргумента.

('1', 'a')

('2', 'b')

('3', 'c')

При вызове функции map все задания будут немедленно переданы в пул потоков, даже если вы не будете итерировать итерабель результатов.

В отличие от встроенной функции map(), которая является ленивой и не вычисляет каждый вызов, пока вы не запросите результат во время итерации.

Приведенный ниже пример подтверждает это, выдавая все задания с картой и не итерируя результаты.

# SuperFastPython.com

# example of calling map and not iterating the results

from time import sleep

from random import random

from concurrent.futures import ThreadPoolExecutor

# custom task that will sleep for a variable amount of time

def task(value):

# sleep for less than a second

sleep(random())

print(f'Done: {value}')

return value

# start the thread pool

with ThreadPoolExecutor() as executor:

# submit all tasks

executor.map(task, range(5))

print('All done!')

Запустив пример, мы видим, что задачи отправляются в пул потоков и выполняются без необходимости явно передавать итерабель результатов, который был возвращен.

Использование менеджера контекста позволило не завершать работу пула потоков до тех пор, пока все задачи не будут выполнены.

Done: 0

Done: 2

Done: 1

Done: 3

Done: 4

All done!

Отправить и использовать как завершенный

Пожалуй, второй наиболее распространенный паттерн при использовании ThreadPoolExecutor - это отправка заданий и использование результатов по мере их поступления.

Этого можно достичь, используя функцию submit() для передачи задач в пул потоков, который возвращает объекты Future, затем вызывая метод модуля as_completed() на списке объектов Future, который будет возвращать каждый объект Future по мере выполнения его задачи.

Пример ниже демонстрирует эту схему, представляя задания в порядке от 0 до 9 и показывая результаты в том порядке, в котором они были выполнены.

# SuperFastPython.com

# example of the submit and use as completed pattern for the ThreadPoolExecutor

from time import sleep

from random import random

from concurrent.futures import ThreadPoolExecutor

from concurrent.futures import as_completed

# custom task that will sleep for a variable amount of time

def task(name):

# sleep for less than a second

sleep(random())

return name

# start the thread pool

with ThreadPoolExecutor(10) as executor:

# submit tasks and collect futures

futures = [executor.submit(task, i) for i in range(10)]

# process task results as they are available

for future in as_completed(futures):

# retrieve the result

print(future.result())

Запустив пример, мы видим, что результаты извлекаются и выводятся в порядке выполнения заданий, а не в том порядке, в котором задания были отправлены в пул потоков.

5

9

6

1

0

7

3

8

4

2

Подавать и использовать последовательно

Мы можем потребовать результаты выполнения заданий в том порядке, в котором они были представлены.

Это может быть связано с тем, что задания имеют естественную упорядоченность.

Мы можем реализовать этот паттерн, вызывая submit() для каждой задачи, чтобы получить список объектов Future, затем итерируя объекты Future в том порядке, в котором задачи были представлены, и получая результаты.

Основное отличие от шаблона "as completed" заключается в том, что мы перечисляем список фьючерсов напрямую, а не вызываем функцию as_completed().

# process task results in the order they were submitted

for future in futures:

# retrieve the result

print(future.result())

Приведенный ниже пример демонстрирует эту схему, отправляя задания в порядке от 0 до 9 и показывая результаты в том порядке, в котором они были отправлены.

# SuperFastPython.com

# example of the submit and use sequentially pattern for the ThreadPoolExecutor

from time import sleep

from random import random

from concurrent.futures import ThreadPoolExecutor

# custom task that will sleep for a variable amount of time

def task(name):

# sleep for less than a second

sleep(random())

return name

# start the thread pool

with ThreadPoolExecutor(10) as executor:

# submit tasks and collect futures

futures = [executor.submit(task, i) for i in range(10)]

# process task results in the order they were submitted

for future in futures:

# retrieve the result

print(future.result())

Выполнив пример, мы видим, что результаты извлекаются и печатаются в том порядке, в котором задания были отправлены, а не в том, в котором они были выполнены.

0

1

2

3

4

5

6

7

8

9

Отправить и использовать обратный вызов

Возможно, мы не захотим явно обрабатывать результаты, как только они станут доступны; вместо этого мы хотим вызвать функцию для результата.

Вместо того чтобы делать это вручную, как в приведенном выше шаблоне as completed, мы можем заставить пул потоков вызвать функцию для нас с результатом автоматически.

Этого можно добиться, установив обратный вызов на каждый объект Future, вызвав функцию add_done_callback() и передав ей имя функции.

Затем пул потоков будет вызывать функцию обратного вызова по мере завершения каждой задачи, передавая объекты Future для задачи.

Нижеприведенный пример демонстрирует этот шаблон, регистрируя пользовательскую функцию обратного вызова, которая будет применяться к каждой задаче по мере ее выполнения.

# SuperFastPython.com

# example of the submit and use a callback pattern for the ThreadPoolExecutor

from time import sleep

from random import random

from concurrent.futures import ThreadPoolExecutor

# custom task that will sleep for a variable amount of time

def task(name):

# sleep for less than a second

sleep(random())

return name

# custom callback function called on tasks when they complete

def custom_callback(fut):

# retrieve the result

print(fut.result())

# start the thread pool

with ThreadPoolExecutor(10) as executor:

# submit tasks and collect futures

futures = [executor.submit(task, i) for i in range(10)]

# register the callback on all tasks

for future in futures:

future.add_done_callback(custom_callback)

# wait for tasks to complete...

Выполнив пример, мы видим, что результаты извлекаются и печатаются в порядке их выполнения, а не в том порядке, в котором задания были выполнены.

8

0

7

1

4

6

5

3

2

9

Мы можем зарегистрировать несколько обратных вызовов для каждого объекта Future; он не ограничен одним обратным вызовом.

Функции обратного вызова вызываются в том порядке, в котором они были зарегистрированы для каждого объекта Future.

Следующий пример демонстрирует наличие двух обратных вызовов для каждого Future.

# SuperFastPython.com

# example of the submit and use multiple callbacks for the ThreadPoolExecutor

from time import sleep

from random import random

from concurrent.futures import ThreadPoolExecutor

# custom task that will sleep for a variable amount of time

def task(name):

# sleep for less than a second

sleep(random())

return name

# custom callback function called on tasks when they complete

def custom_callback1(fut):

# retrieve the result

print(f'Callback 1: {fut.result()}')

# custom callback function called on tasks when they complete

def custom_callback2(fut):

# retrieve the result

print(f'Callback 2: {fut.result()}')

# start the thread pool

with ThreadPoolExecutor(10) as executor:

# submit tasks and collect futures

futures = [executor.submit(task, i) for i in range(10)]

# register the callbacks on all tasks

for future in futures:

future.add_done_callback(custom_callback1)

future.add_done_callback(custom_callback2)

# wait for tasks to complete...

Выполнив пример, мы видим, что результаты сообщаются в порядке выполнения задач и что две функции обратного вызова вызываются для каждой задачи в том порядке, в котором мы зарегистрировали их для каждого объекта Future.

Callback 1: 3

Callback 2: 3

Callback 1: 9

Callback 2: 9

Callback 1: 7

Callback 2: 7

Callback 1: 2

Callback 2: 2

Callback 1: 0

Callback 2: 0

Callback 1: 5

Callback 2: 5

Callback 1: 1

Callback 2: 1

Callback 1: 8

Callback 2: 8

Callback 1: 4

Callback 2: 4

Callback 1: 6

Callback 2: 6

Отправить и ждать всех

Обычно нужно отправить все задания, а затем дождаться завершения всех заданий в пуле потоков.

Этот шаблон может быть полезен, когда задачи не возвращают результат напрямую, например, если каждая задача хранит результат в каком-либо ресурсе, например, в файле.

Для ожидания завершения задач существует два способа: вызов функции модуля wait() или вызов shutdown().

Наиболее вероятный случай - вы хотите явно дождаться завершения набора или подмножества задач в пуле потоков.

Вы можете добиться этого, передав список задач в функцию wait(), которая по умолчанию будет ждать завершения всех задач.

# wait for all tasks to complete

wait(futures)

Мы можем явно указать на ожидание всех задач, установив аргумент "return_when" в константу ALL_COMPLETED; например:

# wait for all tasks to complete

wait(futures, return_when=ALL_COMPLETED)

<<<Пример ниже демонстрирует эту схему. Обратите внимание, что мы намеренно игнорируем возврат после вызова wait(), поскольку в данном случае нам не нужно его проверять.

# SuperFastPython.com

# example of the submit and wait for all pattern for the ThreadPoolExecutor

from time import sleep

from random import random

from concurrent.futures import ThreadPoolExecutor

from concurrent.futures import wait

# custom task that will sleep for a variable amount of time

def task(name):

# sleep for less than a second

sleep(random())

# display the result

print(name)

# start the thread pool

with ThreadPoolExecutor(10) as executor:

# submit tasks and collect futures

futures = [executor.submit(task, i) for i in range(10)]

# wait for all tasks to complete

wait(futures)

print('All tasks are done!')

Запустив пример, мы видим, что результаты обрабатываются каждой задачей по мере ее выполнения. Важно отметить, что главный поток ожидает завершения всех задач, прежде чем продолжить выполнение и вывести сообщение.

3

9

0

8

4

6

2

1

5

7

All tasks are done!

Альтернативный подход заключается в том, чтобы выключить пул потоков и дождаться завершения всех выполняемых и поставленных в очередь задач, прежде чем двигаться дальше.

Это может быть предпочтительнее, когда у нас нет списка объектов Future или когда мы собираемся использовать пул потоков только один раз для набора задач.

Мы можем реализовать этот паттерн с помощью менеджера контекста; например:

# SuperFastPython.com

# example of the submit and wait for all with shutdown pattern for the ThreadPoolExecutor

from time import sleep

from random import random

from concurrent.futures import ThreadPoolExecutor

# custom task that will sleep for a variable amount of time

def task(name):

# sleep for less than a second

sleep(random())

# display the result

print(name)

# start the thread pool

with ThreadPoolExecutor(10) as executor:

# submit tasks and collect futures

futures = [executor.submit(task, i) for i in range(10)]

# wait for all tasks to complete

print('All tasks are done!')

Запустив пример, мы видим, что главный поток не переходит к печати сообщения до тех пор, пока не будут выполнены все задачи, после того как пул потоков будет автоматически закрыт менеджером контекста.

1

2

8

4

5

3

9

0

7

6

All tasks are done!

Шаблон автоматического отключения контекстного менеджера может смутить разработчиков, не знакомых с работой пулов потоков, поэтому в предыдущем примере в конце блока контекстного менеджера есть комментарий.

Мы можем добиться того же эффекта без менеджера контекста и явного вызова shutdown.

# wait for all tasks to complete and close the pool

executor.shutdown()

Напомните, что функция shutdown() по умолчанию будет ждать завершения всех задач и не отменит ни одной поставленной в очередь задачи, но мы можем сделать это явным, установив аргумент "wait" в True и аргумент "cancel_futures" в False; например:

# wait for all tasks to complete and close the pool

executor.shutdown(wait=True, cancel_futures=False)

Приведенный ниже пример демонстрирует модель ожидания завершения всех задач в пуле потоков путем вызова shutdown(), прежде чем двигаться дальше.

# SuperFastPython.com

# example of the submit and wait for all with shutdown pattern for the ThreadPoolExecutor

from time import sleep

from random import random

from concurrent.futures import ThreadPoolExecutor

# custom task that will sleep for a variable amount of time

def task(name):

# sleep for less than a second

sleep(random())

# display the result

print(name)

# start the thread pool

executor = ThreadPoolExecutor(10)

# submit tasks and collect futures

futures = [executor.submit(task, i) for i in range(10)]

# wait for all tasks to complete

executor.shutdown()

print('All tasks are done!')

Запустив пример, мы видим, что все задачи сообщают о своем результате по мере завершения и что главный поток не переходит к выполнению до тех пор, пока все задачи не будут завершены и пул потоков не будет закрыт.

3

5

2

6

8

9

7

1

4

0

All tasks are done!

Отправить и ждать первого

Обычно можно выдать много заданий, и беспокоиться только о первом полученном результате.

То есть не результат первой задачи, а результат любой задачи, которая первой завершает свое выполнение.

Это может произойти, если вы пытаетесь получить доступ к одному и тому же ресурсу из нескольких мест, например к файлу или каким-то данным.

Этого можно добиться, используя функцию модуля wait() и установив аргумент "return_when" в константу FIRST_COMPLETED.

# wait until any task completes

done, not_done = wait(futures, return_when=FIRST_COMPLETED)

Мы также должны управлять пулом потоков вручную, создавая его и вызывая shutdown() вручную, чтобы мы могли продолжить выполнение главного потока, не дожидаясь завершения всех остальных задач.

Приведенный ниже пример демонстрирует эту схему и прекращает ожидание, как только первая задача будет выполнена.

# SuperFastPython.com

# example of the submit and wait for first the ThreadPoolExecutor

from time import sleep

from random import random

from concurrent.futures import ThreadPoolExecutor

from concurrent.futures import wait

from concurrent.futures import FIRST_COMPLETED

# custom task that will sleep for a variable amount of time

def task(name):

# sleep for less than a second

sleep(random())

return name

# start the thread pool

executor = ThreadPoolExecutor(10)

# submit tasks and collect futures

futures = [executor.submit(task, i) for i in range(10)]

# wait until any task completes

done, not_done = wait(futures, return_when=FIRST_COMPLETED)

# get the result from the first task to complete

print(done.pop().result())

# shutdown without waiting

executor.shutdown(wait=False, cancel_futures=True)

Запустив пример, мы дождемся завершения любой из задач, затем получим результат первой выполненной задачи и выключим пул потоков.

Важно, что задачи будут продолжать выполняться в пуле потоков в фоновом режиме, а главный поток не будет закрываться до тех пор, пока все задачи не завершатся.

9

Теперь, когда мы рассмотрели некоторые общие шаблоны использования ThreadPoolExecutor, давайте посмотрим, как мы можем настроить конфигурацию пула потоков.

Как настроить ThreadPoolExecutor

Мы можем настроить конфигурацию пула потоков при создании экземпляра ThreadPoolExecutor.

Есть три аспекта пула потоков, которые мы можем захотеть настроить для нашего приложения; это количество рабочих потоков, имена потоков в пуле и инициализация каждого потока в пуле.

Давайте рассмотрим каждый из них по очереди.

Настройте количество потоков

Количество потоков в пуле потоков может быть задано аргументом "max_workers".

Он принимает целое положительное число и по умолчанию равен количеству процессоров в вашей системе плюс четыре.

- Общее количество рабочих потоков = (CPU в вашей системе) + 4

Например, если у вас в системе 2 физических процессора и каждый из них имеет гиперпоточность (распространенную в современных процессорах), то у вас будет 2 физических и 4 логических процессора. Python будет видеть 4 процессора. Тогда количество рабочих потоков в вашей системе по умолчанию будет равно (4 + 4) или 8.

Если это число окажется больше 32 (например, 16 физических ядер, 32 логических ядра, плюс четыре), то по умолчанию верхняя граница будет ограничена 32 потоками.

Обычно в системе больше потоков, чем процессоров (физических или логических).

Причина этого в том, что потоки используются для задач, связанных с IO, а не с процессором. Это означает, что потоки используются для задач, которые ждут ответа от относительно медленных ресурсов, таких как жесткие диски, DVD-приводы, принтеры, сетевые соединения и многое другое. Мы обсудим наилучшее применение потоков в следующем разделе.

Поэтому нередко в приложении могут быть десятки, сотни и даже тысячи потоков, в зависимости от ваших конкретных потребностей. Необычно иметь более одного или нескольких тысяч потоков. Если вам требуется такое количество потоков, то можно предпочесть альтернативные решения, например AsyncIO. Мы обсудим Threads vs. AsyncIO в одном из следующих разделов.

Сначала давайте проверим, сколько потоков создано для пулов потоков в вашей системе.

Взглянув на исходный код ThreadPoolExecutor, мы увидим, что количество рабочих потоков, выбранных по умолчанию, хранится в свойстве _max_workers, к которому мы можем получить доступ и сообщить о нем после создания пула потоков.

Примечание: "_max_workers" является защищенным членом и может измениться в будущем.

В приведенном ниже примере сообщается о количестве потоков по умолчанию в пуле потоков вашей системы.

# SuperFastPython.com

# report the default number of worker threads on your system

from concurrent.futures import ThreadPoolExecutor

# create a thread pool with the default number of worker threads

pool = ThreadPoolExecutor()

# report the number of worker threads chosen by default

print(pool._max_workers)

Запуск примера сообщает о количестве рабочих потоков, используемых по умолчанию в вашей системе.

У меня четыре физических ядра процессора и восемь логических ядер; поэтому по умолчанию используется 8 + 4 или 12 потоков.

12

Сколько рабочих потоков выделено по умолчанию в вашей системе?

Дайте мне знать в комментариях ниже.

Мы можем указать количество рабочих потоков напрямую, и это хорошая идея в большинстве приложений.

В примере ниже показано, как настроить 500 рабочих потоков.

# SuperFastPython.com

# configure and report the default number of worker threads

from concurrent.futures import ThreadPoolExecutor

# create a thread pool with a large number of worker threads

pool = ThreadPoolExecutor(500)

# report the number of worker threads

print(pool._max_workers)

Запуск примера настраивает пул потоков на использование 500 потоков и подтверждает, что он создаст 500 потоков.

500

Сколько нитей следует использовать?

Если у вас сотни задач, вам, вероятно, следует установить количество потоков равным количеству задач.

Если у вас тысячи задач, вам, вероятно, следует ограничить количество потоков сотнями или 1 000.

Если ваше приложение предполагается выполнять несколько раз в будущем, вы можете протестировать разное количество потоков и сравнить общее время выполнения, а затем выбрать количество потоков, которое дает примерно наилучшую производительность. Возможно, вы захотите сымитировать задачу в этих тестах с помощью случайной операции сна.

Настройте имена потоков

У каждого потока в Python есть имя.

Главный поток имеет имя "MainThread". Вы можете получить доступ к главному потоку через вызов функции main_thread() в модуле потоков и затем получить доступ к члену name. Например:

# access the name of the main thread

from threading import main_thread

# access the main thread

thread = main_thread()

# report the thread name

print(thread.name)

Запуск примера открывает доступ к главному потоку и сообщает его имя.

MainThread

Имена по умолчанию уникальны.

Это может быть полезно при отладке программы с несколькими потоками. Сообщения журнала могут сообщать о потоке, выполняющем определенный шаг, или отладка может быть использована для отслеживания потока с определенным именем.

При создании потоков в пуле потоков каждый поток имеет имя "ThreadPoolExecutor-%d_%d", где первый %d указывает номер пула потоков, а второй %d - номер потока, причем оба в порядке создания пулов потоков и потоков.

Мы можем увидеть это, если обратимся к потокам непосредственно внутри пула после выделения некоторого количества работы, чтобы все потоки были созданы.

Мы можем перечислить все потоки в программе (процессе) Python с помощью функции enumerate() в модуле threading, а затем сообщить имя каждого из них.

В приведенном ниже примере создается пул потоков с количеством потоков по умолчанию, выделяется работа для пула, чтобы обеспечить создание потоков, затем сообщаются имена всех потоков в программе.

# SuperFastPython.com

# report the default name of threads in the thread pool

import threading

from concurrent.futures import ThreadPoolExecutor

# a mock task that does nothing

def task(name):

pass

# create a thread pool

executor = ThreadPoolExecutor()

# execute asks

executor.map(task, range(10))

# report all thread names

for thread in threading.enumerate():

print(thread.name)

# shutdown the thread pool

executor.shutdown()

Запуск примера сообщает имена всех потоков в системе, показывая сначала имя главного потока и имена четырех потоков в пуле.

В данном случае было создано всего 4 потока, поскольку задания выполнялись так быстро. Напомним, что рабочие потоки используются после того, как они завершают выполнение своих задач. Эта возможность повторного использования рабочих потоков является основным преимуществом использования пулов потоков.

MainThread

ThreadPoolExecutor-0_0

ThreadPoolExecutor-0_1

ThreadPoolExecutor-0_2

ThreadPoolExecutor-0_3

"ThreadPoolExecutor-%d" является префиксом для всех потоков в пуле потоков, и мы можем настроить его с именем, которое может быть значимым в приложении для типов задач, выполняемых пулом.